https://mp.weixin.qq.com/s/RtdF3dDlngCvpPZf3gdujg

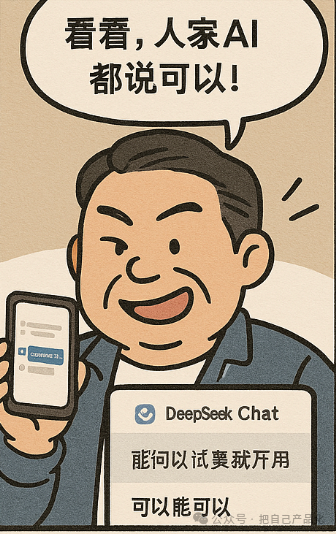

我一时间竟有些懵,不知如何应对,只好半开玩笑地说:“那你换个方式再问它一次,答案八成会变。”结果,他果然没再吭声了……

这件事让我哭笑不得,也让我意识到,当人们过度依赖AI时,反而可能忽略专业人士的判断,闹出这种“信任危机”。

这让我不禁联想到更广的场景。比如,医生和打工人可能很快就会深有体会。

想象一下,未来可能会有更多自以为是的患者拿着医生的话去问AI:“他说这个病得这么治,靠谱吗?”或者老板拿着员工的汇报丢给AI:“他说这个方案可行,真的假的?”然后,他们再拿着AI生成的一堆“权威”答案回来质问。

是不是也挺魔幻的?AI本该是辅助我们的工具,可一旦落入缺乏判断力的人手里,反而可能变成“杠精放大器”。让他们更有底气去挑战专业意见。

医生可能得应付“我在AI上查了,你开的药不对”的病人;打工人则得面对“AI说你的方案效率低,你是不是偷懒了”的老板。

到头来,专业知识和经验没被尊重,反而得跟AI抢“话语权”,真是既心酸又好笑。

为什么会这样?很大程度上,这源于人们对AI的“权威性误解”。AI常被包装成“智能”“高效”的代名词,带着一层技术光环,让人觉得它天然比人工判断更可靠。加上它回答问题快,能瞬间给出“答案”,这种“即时满足”也让不少人懒得再去验证。更关键的是,很多人并不了解AI的局限性——比如幻觉……

就像开头提到的那位“大哥”,他宁愿信AI,也不信我这个实际操作过的人。我让他“换个方式再问”,其实是想点出AI的不稳定性:它可能因为问题表述不同就给出截然相反的答案。

所以说,AI现在就处在这个“能信,但不能全信”的尴尬状态。它的回答有时让人觉得可信,有时又让人拿不准。尤其碰到信息模糊或场景复杂的问题时(比如我并不建议直接问“某某东西能吃吗”“某某好不好”这种),它的准确性和权威性未必靠得住。

这事儿让我感慨良多。AI的确是好工具,能帮我们省时省力,但它绝不是万能的“真理机器”。适度怀疑并保持批判性思维总是很有必要的(不要光怀疑人,AI也要怀疑下……)。合理地运用AI的优势,并结合自己的判断,才能做到最好。

未来,当患者、老板,甚至身边的“大哥”们再拿着AI的答案来质疑我们时,也许我们可以淡定地说一句:“AI说得挺好,但,——要不你再问问它?”

毕竟,AI是助手,不是裁判,真正靠谱的,还是我们自己的脑子。